Embora o limite tenha caído de 15 MB para 2 MB, a maioria dos sites não será afetada. Veja como garantir que o conteúdo principal da sua página continue sendo lido e indexado corretamente.

Se você acompanha as atualizações de documentações do Google, provavelmente deve ter visto o burburinho: o limite de rastreamento do Googlebot caiu de 15 MB para 2 MB.

Para quem lê apenas a manchete, o susto é grande. “Meu site tem imagens mais pesadas, o Google vai parar de ler minha página?”. A resposta curta é: provavelmente não. Na documentação oficial do Googlebot, o Google diz que, para Search, o crawler considera os primeiros 2 MB de cada arquivo compatível (como HTML, JS, CSS ou TXT) No caso de PDFs, o limite permanece em 64 MB.

Resumo prático: para a maioria dos sites, não muda nada. Dados do Web Almanac (HTTP Archive) mostram que o HTML costuma ser bem menor do que 2 MB. Se o seu site está próximo disso, quase sempre é HTML inflado por códigos inline, Base64 ou alguma estrutura repetida.

O antes e o depois: o que mudou?

Até pouco tempo atrás, o Googlebot era “mais generoso” (ou, talvez, menos eficiente). Ele baixava e processava arquivos de até 15 MB antes de “cortar” o conteúdo.

| Como era (até Jan/2026) | Como ficou (Fev/2026) | |

| Limite por arquivo | 15 MB | 2 MB |

| Tipo de arquivo | HTML, JS, CSS, TXT | HTML, JS, CSS, TXT |

| PDFs | 50-64 MB | 64 MB (Mantido) |

| Imagens/Vídeos | Processados à parte | Processados à parte |

A regra de ouro continua a mesma: o limite de 2 MB é aplicado a cada arquivo individualmente, e não à soma de todos os elementos da sua página.

Devo me preocupar com minhas imagens?

Este é o ponto que muita gente confunde. Quando o Google acessa uma URL, ele baixa o HTML bruto. Dentro desse código, existem apenas “instruções” (links) dizendo onde as imagens estão hospedadas.

O Googlebot lê o HTML (que raramente passa de 200 KB), identifica o link da imagem e passa essa tarefa para o Googlebot-Image. A imagem é um recurso externo e tem seu próprio processo de rastreamento. Portanto, se você tem uma página com 10 MB de fotos, mas seu HTML tem 150 KB, o Google lerá o texto e os links da sua página inteira sem qualquer dificuldade.

O perigo real: o limite de 2 MB só é um problema se você usa imagens em Base64 (transformar a imagem em código direto no HTML) ou se o seu arquivo de JavaScript/CSS único for gigantesco e mal otimizado. Se for o seu caso, recomendo urgentemente a leitura do Guia Fundamental dos Core Web Vitals.

Como saber se meu site pode ser afetado pelo Google?

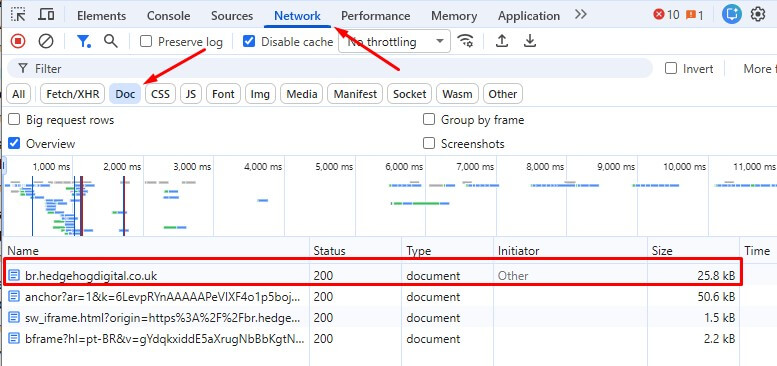

Vamos te ensinar agora como checar em 1 minuto usando o Chrome DevTools:

- Abra sua página no Chrome e aperte F12

- Vá em Network e recarregue a página

- Clique no filtro Doc para pegar o HTML principal

- Olhe a coluna Size do documento

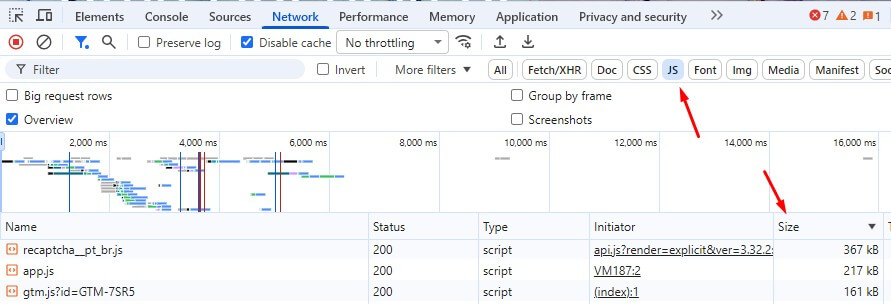

- Clique em JS, ordene por Size e veja os maiores arquivos

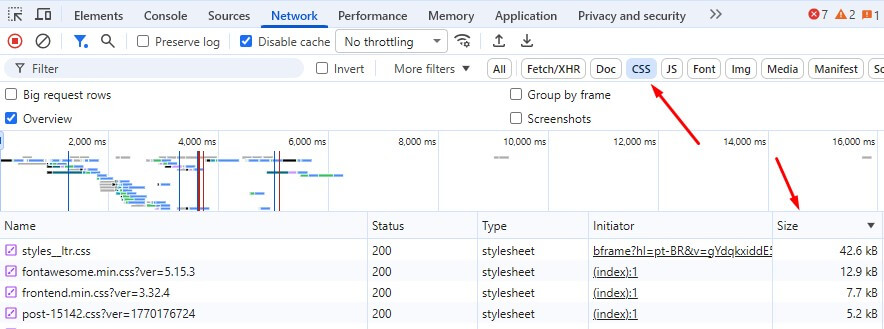

- Clique em CSS, ordene por Size e veja os maiores

O Chrome DevTools já resolve a dúvida na maioria dos casos, mas se ainda não está satisfeito com essa análise, dá para complementar com log do servidor e observar o comportamento do Googlebot.

O que fazer se você descobrir que está perto do limite

Se esse for o seu caso, saiba que seu site estará fora dos padrões normais, mas, é possível corrigir isso com os passos abaixo:

- reduza o HTML repetido e markup desnecessário

- evite Base64 no HTML

- diminua códigos inline (CSS/JS)

- revise bundles grandes que estão carregando sem necessidade

Se você já faz auditorias de SEO, esse tema encaixa bem com performance e renderização.

Perguntas frequentes (FAQ)

Isso vai derrubar meu tráfego?

Quase nunca. Só vira risco real se seu HTML ou recursos essenciais estiverem gigantes a ponto do Google parar de buscar antes de chegar no que importa.

Meu site tem imagens em 4K. O Google vai me ignorar?

Não. Como as imagens são arquivos separados (.jpg, .png), elas não somam no limite do arquivo HTML. O Googlebot lerá o código da página normalmente e o robô de imagens indexará suas fotos depois.

O limite de 2 MB é para o arquivo compactado (Gzip)?

Não. O Google considera o tamanho do arquivo descompactado. Se o seu servidor envia um HTML compactado de 1 MB, mas que vira 2.5 MB quando o navegador abre, o Google cortará os 500 KB finais.

O que acontece se meu HTML passar de 2 MB?

O Google vai ler apenas os primeiros 2 MB. Tudo o que estiver abaixo disso no código, como: links internos, textos importantes ou dados estruturados, será totalmente ignorado, como se não existisse na página.

Se você deseja construir uma base técnica sólida, e garantir que seu site esteja preparado para qualquer atualização do Google, conte com a Hedgehog, uma agência de SEO que vai além do básico e te entrega o que há de melhor e mais avançado em análises e otimizações.